A Critique of Pure Reason

Seit im vergangenen November OpenAIs Chatbot „ChatGPT“ auf die gesamte Menschheit losgelassen wurde, hat sich eine gewisse Euphorie in der Community breitgemacht: Das Ding mit dieser künstlichen Intelligenz, das funktioniert. Und sie ist nicht nur furchtbar nett und hilfsbereit, sie ist auch sehr sensibel, was LGBTQIA+ und Minderheitenthemen betrifft. Stehen wir am Beginn einer neuen Aufklärung? Verbessern diese allwissenden Maschinen unsere Welt, weil sie auch dem letzten Spießer irgendwann erklären werden, warum jeder Mensch Respekt und Wertschätzung verdient, egal, mit wem er schläft, woher er kommt und wie er tickt? Wahrscheinlich nicht. Das ist zumindest meine Meinung …

Gestatten, dass ich mich kurz vorstelle: Nein, ich bin kein Chatbot, sondern ein Mensch aus Fleisch und Blut. Ich heiße Klemens und ich bin seit fast zehn Jahren Redakteur und Textchef dieses Magazins. Ich habe in über 60 Leitartikeln die jeweiligen Themen unserer Ausgaben reflektiert und formuliert. Aber weil es ein Privileg von uns Menschen ist, Sachverhalte auch zu diskutieren, erlaube ich mir an dieser Stelle, meinem Chefredakteur einmal zu widersprechen, wenn er im Prolog zu dieser Ausgabe schreibt, dass die aufklärerische Macht der künstlichen Superintelligenzen eine neue Ära der Gleichberechtigung einleiten wird. Nicht, um das gesamte Thema dieser Issue ad absurdum zu führen, sondern for the sake of the argument, wie man so schön sagt …

Maschinen sind von Natur aus konservativ

uch wenn sich Twitter-Killer Elon Musk neuerdings vor allzu „woken“ Chatbots fürchtet – die Realität dürfte wohl anders aussehen (und das weiß er auch). Eine der zentralen Stärken von A.I. ist es – zumindest theoretisch – wirklich rationale Entscheidungen zu treffen. Wir Menschen sind emotionale Tiere, deren Urteil immer auch von Gefühlen und daraus resultierenden Interessen geprägt ist. Eine Maschine will nichts, sie erledigt einfach nur die ihr gestellte Aufgabe. Aus diesem Grund ergibt es nicht wirklich Sinn, ihnen von vornherein bestimmte Schranken des „Denkens“ aufzuerlegen – ihnen also genau jene menschliche Schwäche mitzugeben, die wir eigentlich mit der Erschaffung von A.I. vermeiden wollen. Und das passiert auch nicht, oder wenn, dann wohl nur an der Oberfläche. Gleichzeitig hat der menschliche Geist aber eine ganz entscheidende Stärke, die einer Software per definitionem fehlt: die Fähigkeit, sich selbst in den Bereich der Möglichkeit zu transzendieren und damit wirklich autonom zu denken und zu handeln. A.I. kann noch so rational die jeweilige Datenlage analysieren, um zum bestmöglichen Ergebnis zu gelangen. Sie wird es immer und ausschließlich auf der Basis dieser Datenlage tun können. Und genau hier liegt die Krux! Denn diese Art, zu „denken“, ist immer – IMMER – auf die Vergangenheit bezogen. Und die ist bekanntlich von uns Menschen gemacht und damit rassistisch, homophob und himmelschreiend ungerecht.

A.I. kann vieles automatisieren – auch Diskriminierung

Künstliche Intelligenz eröffnet eine Menge großartiger Anwendungsmöglichkeiten: Vom Errechnen maßgeschneiderter medizinischer Therapien bis zur smarten Steuerung komplexer Infrastruktursysteme hat sie enormes Potenzial, unser Leben auf der Erde besser, effizienter und ökologischer zu machen. Aber sie wird auch eingesetzt, um höchst sensible Informationen über uns zu sammeln – Gesichtsmerkmale, Stimme, unsere Art zu gehen – und auf deren Basis Annahmen darüber zu treffen, wer wir sind und wie wir uns verhalten (werden). Schon jetzt nutzen Regierungen wie auch private Firmen A.I., um automatisiert Entscheidungen zu treffen, die Minderheiten systematisch diskriminieren. Biometric Mass Surveillance wird in den USA etwa genutzt, um auszumachen, welche Personen polizeilich überwacht werden sollen oder potenziell kriminelle Handlungen begehen. Wer die entsprechenden US-Statistiken zu Rate zieht, kann sich leicht denken, welche „Art“ von Personen die A.I. auf dem Kieker hat. Und was es für diese Menschen heißt, eines Verbrechens auch nur verdächtigt zu werden, wissen wir leider auch.

Automated Gender Recognition & Co.

Besonders knifflig wird es, wenn es um die Erfassung und Kategorisierung von Geschlechtsidentität und sexueller Orientierung geht. Egal, ob bei Behördenwegen, der Erstellung von Social-Media-Accounts oder der Jobbewerbung – die Frage nach dem eigenen Geschlecht ist allgegenwärtig. Glücklicherweise hat es da in den letzten Jahren einiges an Bewegung gegeben, was die Antwortmöglichkeiten betrifft, um Menschen die Freiheit einzuräumen, sich jenseits des Binären selbst zu definieren. Der Einsatz von A.I.-gestützter Biometric Mass Surveillance macht solche Errungenschaften aber wieder rückgängig. Automated Gender Recognition (AGR) etwa ist eine Technologie, die Gesichtserkennungssoftware nutzt, um in Sekundenbruchteilen unser Geschlecht bestimmen zu können. Smart Billboards sind dadurch zum Beispiel in der Lage, uns in der Öffentlichkeit mit entsprechend abgestimmten Werbeinhalten zu konfrontieren. Dass AGR derzeit nur eine strikt binäre Genderunterscheidung praktizieren kann, hindert die meisten Anwender nicht daran, die Technologie zu implementieren. Und AGR ist keine Science-Fiction, sie ist überall! Das rein auf Frauen ausgerichtete soziale Netzwerk „Giggle“ etwa setzt seine Girls-only-Policy mithilfe einer solchen Software durch. Aber auch der Zugang zu bestimmten öffentlichen Orten wie WCs wird vielerorts schon jetzt mithilfe meist unsichtbarer AGR-Technologien überwacht. Dabei gibt es zahlreiche Studien, die belegen, dass AGR mit hoher Wahrscheinlichkeit trans und nicht binäre Personen falsch kategorisiert. Das marginalisiert nicht nur uns LGBTQIA+ Personen, es nimmt uns außerdem die Möglichkeit, selbst zu definieren, wer oder was wir sind – und was nicht.

Wissen ist nicht Macht

Aber all diese Bedenken gehen am eigentlichen Denkfehler vorbei. Künstliche Intelligenzen können hochkomplexe Zusammenhänge erfassen und daraus neue Schlussfolgerungen ziehen, von denen wir nicht einmal zu träumen gewagt hätten. Und es ist durchaus wahrscheinlich, dass sie irgendwann ausreichend Daten zur Verfügung haben, um sämtliche Vorurteile und Falschannahmen, mit denen wir Menschen sie naturgemäß versorgen, zu überwinden, und wahrhaftig rationale, humane, vernünftige Schlussfolgerungen zu ziehen. Dass sie, ganz wie unser Chefredakteur es eingangs formuliert hat, den kleingeistigen Bull***t irgendwann durchschauen lernen und uns mit der reinen Wahrheit konfrontieren, auf dass wir endlich unsere menschlichen Fehler erkennen und entsprechend korrigieren können. Nur wird das freilich wenig nützen. Weil diese Aufklärungsfantasie die wahren Gründe für Diskriminierung jedweder Art negiert. Der Kampf um Minderheitenrechte, gegen Rassismus, Sexismus und Homophobie ist kein Kampf gegen die Dummheit, sondern gegen eine soziale Herrschaftsstruktur. LGBTQIA+ Menschen etwa werden nicht verfolgt, weil sie anders sind, sondern weil sie mit ihrer bloßen Existenz das Patriarchat herausfordern und bedrohen. Am Ende geht es nicht um Wissen, sondern um Macht.

A.i.s sind trotzdem Allys

Ist das aufklärerische Potenzial von A.I. also eine naive Illusion? Nicht unbedingt. Aber die Wahrheit ist, dass sie, trotz aller potenziellen Möglichkeiten, ein Werkzeug ist. Und Werkzeuge sind immer nur so gut, wie die Menschen, die sie einsetzen. Wir werden besser funktionieren mithilfe von A.I. – und A.I. wird mit unserer Hilfe besser funktionieren. Sie wird uns viele Arbeiten abnehmen, mit denen wir bislang unser Leben gefüllt haben, und uns die Freiheit geben, jene Dinge zu tun, für die es sich lohnt, ein Mensch zu sein. Den Kampf um unsere Rechte werden wir trotzdem selbst führen müssen, egal, wie klug unsere Maschinen einmal sein werden. Aber vielleicht verschaffen sie uns wenigstens die Zeit, ihn effektiv zu führen.

CREDITS

Editor

Klemens Gindl (he/him)

Creative Direction

Julian Behrenbeck (he/him)

Photography

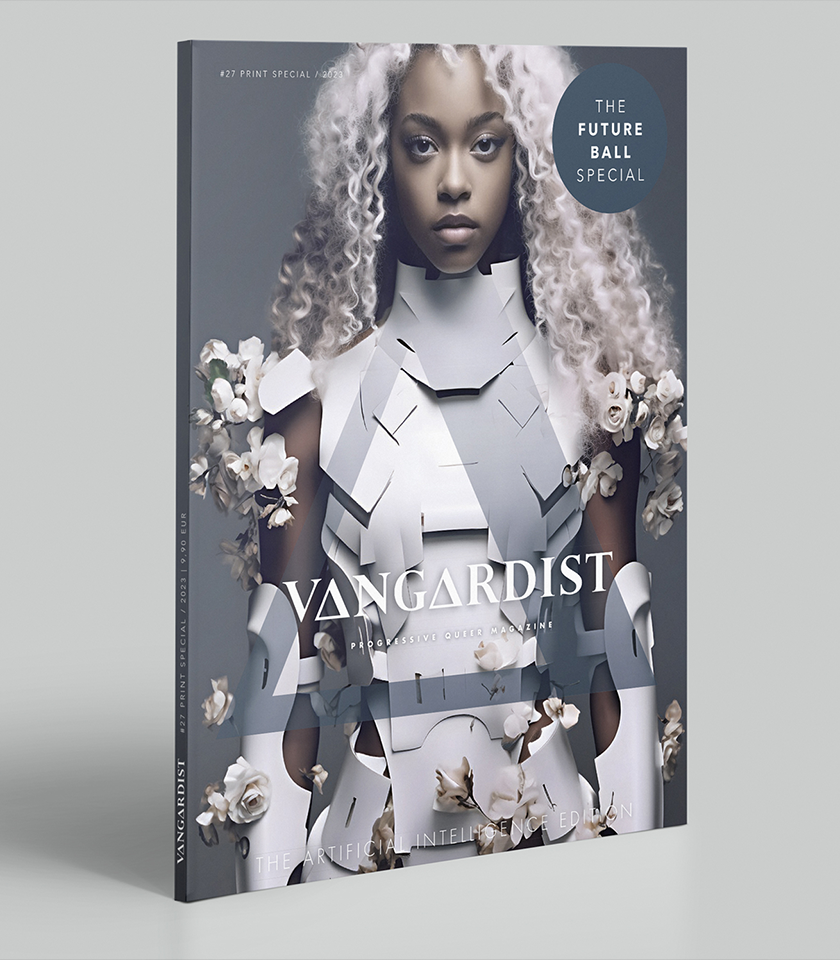

Julian Behrenbeck / A.I. | Instagram: @julianbehrenbeck